从AI服务器谈HBM、HBM2、HBM3、HBM3e技术

HBM:突破显存瓶颈,释放AI服务器性能

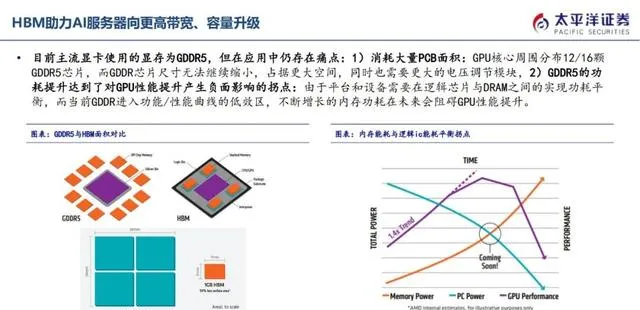

HBM(高带宽存储)是专为满足AI服务器GPU显存需求而设计的创新存储解决方案。它采用多层DRAM Die垂直堆叠技术,通过TSV穿透硅通孔技术实现与逻辑Die连接,使8层或12层Die封装于小体积空间中,实现小尺寸、高带宽、高传输速度的兼容。

HBM的优势在于:

* 带宽更大:HBM的带宽可达传统显存的数倍,满足AI服务器对数据吞吐量的巨大需求。

* 体积更小:HBM的体积仅为传统显存的几分之一,有助于减小AI服务器的整体尺寸。

* 功耗更低:HBM的功耗更低,可有效降低AI服务器的运行成本。

HBM技术已经成为高性能AI服务器GPU显存的主流解决方案,为AI服务器的性能提升提供了坚实的基础。即高带宽存储,由多层DRAM Die垂直堆叠,每层Die通过TSV穿透硅通孔技术实现与逻辑Die连接,使得8层、12层Die封装于小体积空间中,从而实现小尺寸于高带宽、高传输速度的兼容,成为高性能AI服务器GPU显存的主流解决方案。

HBM3E:更高速度、更大容量的内存解决方案

SK海力士率先发布HBM3E,这是HBM3的扩展版本,提供高达8Gbps的传输速度和16GB内存。该内存解决方案将于2024年量产,将为下一代高性能计算、人工智能和图形应用提供强大的支持。

HBM3E的特点

- 传输速度高达8Gbps,比HBM3提高了50%。

- 内存容量高达16GB,是HBM3的两倍。

- 功耗更低,可满足下一代高性能计算应用的需求。

HBM3E的应用

- 高性能计算:HBM3E将成为下一代高性能计算系统的关键组件,为科学研究、工程模拟等领域提供强大的计算能力。

- 人工智能:HBM3E也将成为人工智能应用的关键组件,为机器学习、深度学习等领域提供强大的数据处理能力。

- 图形应用:HBM3E还将成为图形应用的关键组件,为游戏、虚拟现实等领域提供强大的图形处理能力。HBM3的扩展版本HBM3E,提供高达8Gbps的传输速度和16GB内存,由SK海力士率先发布,将于2024年量。

HBM:引领AI服务器高速发展

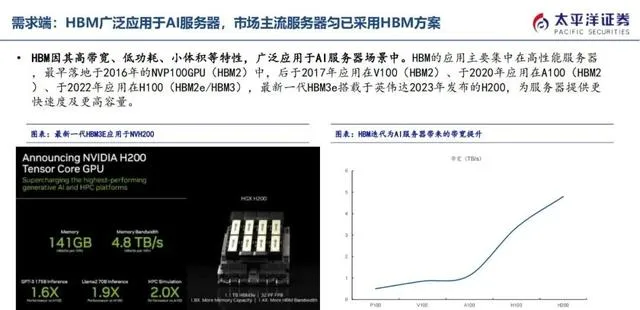

HBM(High Bandwidth Memory)以其超高带宽和低功耗的优势,成为AI服务器的理想内存解决方案。最新一代HBM3e搭载于英伟达2023年发布的p00,为AI计算提供更强大的动力。

据Trendforce数据,2022年AI服务器出货量达到86万台,预计2026年将超过200万台,年复合增长率高达29%。随着AI应用的不断扩展,HBM市场也将迎来爆发式增长。

作为HBM领域的领导者,我们致力于提供高性能、低功耗的HBM解决方案,助力AI服务器行业实现快速发展。主要应用场景为AI服务器,最新一代HBM3e搭载于英伟达2023年发布的p00。根据Trendforce数据,2022年AI服务器出货量86万台,预计2026年AI服务器出货量将超过200万台,年复合增速29%。

AI服务器HBM需求爆发,市场规模迅猛增长

● AI服务器出货量大幅增长,带动HBM需求爆发。

● 服务器平均HBM容量不断增加,进一步推动市场需求。

● 预计2025年HBM市场规模将达150亿美元,年复合增长率超过50%。服务器出货量增长催化HBM需求爆发,且伴随服务器平均HBM容量增加,经测算,预期25年市场规模约150亿美元,增速超过50%。

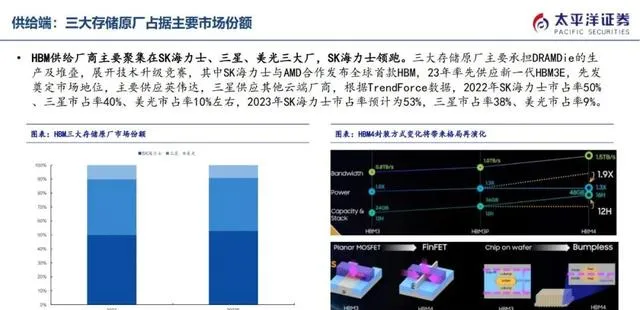

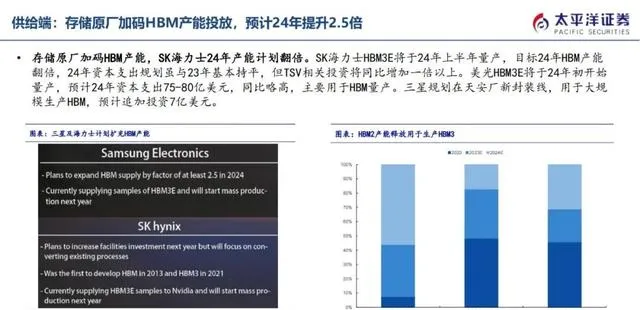

三强鼎立,SK海力士领跑HBM市场。2023年,SK海力士市占率预计达53%,三星紧随其后,市占率为38%,而美光则为9%。

工艺演进,CoWoS和TSV引领风潮。HBM在工艺上不断革新,以追求更高的带宽和更低的功耗。CoWoS (Chip-on-Wafer-on-Substrate) 和 TSV (Through-Silicon Via) 等技术正在成为主流。

HBM,引领存储技术新潮流。凭借其超高带宽和低功耗的特性,HBM正在成为高性能计算、人工智能和数据中心等领域的理想选择。供给厂商主要聚集在SK海力士、三星、美光三大存储原厂,根据Trendforce数据,2023年SK海力士市占率预计为53%,三星市占率38%、美光市占率9%。HBM在工艺上的变化主要在CoWoS和TSV。

- 2014年,AMD与SK海力士联手推出HBM1,挑战GDDR显存。

- HBM1采用4层die堆叠设计,提供128GB/s带宽,远超同时期GDDR5显存。

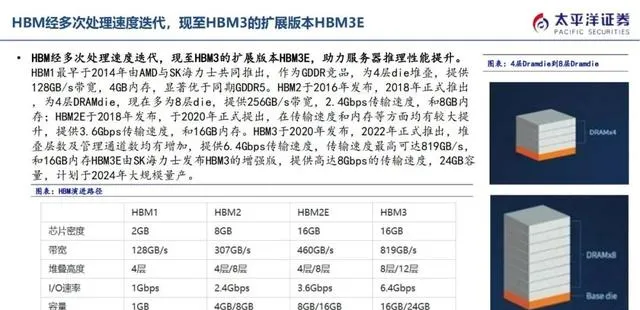

- HBM1内存容量高达4GB,优于同期显存。最早于2014年由AMD与SK海力士共同推出,作为GDDR竞品,为4层die堆叠,提供128GB/s带宽,4GB内存,显著优于同期GDDR5。

HBM系列DRAM技术的发展历程:

- HBM2:

- 发布年份:2016年

- 正式推出:2018年

- DRAM die层数:4层

- 多层die:8层

- 带宽:256GB/s

- 传输速度:2.4Gbps

- 内存:8GB

- HBM2E:

- 发布年份:2018年

- 正式提出:2020年

- 传输速度:3.6Gbps

- 内存:16GB

- HBM3:

- 发布年份:2020年

- 正式推出:2022年

- DRAM die层数:增加

- 管理通道数:增加

- 传输速度:6.4Gbps(最高可达819GB/s)

- 内存:16GB

- HBM3E:

- 发布单位:SK海力士

- 发布年份:待定,计划于2024年大规模量产

- 传输速度:高达8Gbps

- 内存:24GB于2016年发布,2018年正式推出,为4层DRAMdie,现在多为8层die,提供256GB/s带宽,2.4Gbps传输速度,和8GB内存;HBM2E于2018年发布,于2020年正式提出,在传输速度和内存等方面均有较大提升,提供3.6Gbps传输速度,和16GB内存。HBM3于2020年发布,2022年正式推出,堆叠层数及管理通道数均有增加,提供6.4Gbps传输速度,传输速度最高可达819GB/s,和16GB内存HBM3E由SK海力士发布HBM3的增强版,提供高达8Gbps的传输速度,24GB容量,计划于2024年大规模量产。

HBM,全称为高带宽内存,具备传输速度快、功耗低、体积小巧等优势,是AI服务器场景的理想存储解决方案。

自2016年首次应用于NVIDIA的NVP100 GPU(HBM2)以来,HBM得到了业界的广泛认可,相继被采用于V100(HBM2)、A100(HBM2)、p00(HBM2e/HBM3)等系列GPU中。

最新一代的HBM3e内存搭载于英伟达2023年发布的p00 GPU上,进一步提升了速度和容量,为服务器提供了更强大的性能支持。HBM的出现标志着服务器内存技术的发展迈入了一个新时代,其高带宽、低功耗、小体积等特性,为人工智能、深度学习等领域的高性能计算提供了强有力的支撑,并有望在未来发挥更加重要的作用。因其高带宽、低功耗、小体积等特性,广泛应用于AI服务器场景中。HBM的应用主要集中在高性能服务器,最早落地于2016年的NVP100GPU(HBM2)中,后于2017年应用在V100(HBM2)、于2020年应用在A100(HBM2)、于2022年应用在p00(HBM2e/HBM3),最新一代HBM3e搭载于英伟达2023年发布的p00,为服务器提供更快速度及更高容量。

HBM市场概况:

- SK海力士、三星、美光三巨头主导HBM市场,SK海力士领跑;

- 三大厂商专注于DRAM Die生产和堆叠,技术升级竞赛激烈。

SK海力士优势明显:

- 与AMD合作发布全球首款HBM,率先供应新一代HBM3E,奠定市场地位;

- 主要供应英伟达,市占率领先,预计2023年将进一步提升至53%。

三星紧随其后:

- 主要供应其他云端厂商,市占率预计2023年将降至38%;

- 技术实力强劲,与SK海力士展开激烈竞争。

美光稳居第三:

- 市占率预计2023年将降至9%;

- 专注于高端HBM市场,技术研发实力不容小觑。

市场前景:

- HBM市场仍有较大增长潜力,预计未来几年将保持稳定增长;

- 人工智能、5G等新兴技术的发展将对HBM需求产生积极影响。供给厂商主要聚集在SK海力士、三星、美光三大厂,SK海力士领跑。三大存储原厂主要承担DRAMDie的生产及堆叠,展开技术升级竞赛,其中SK海力士与AMD合作发布全球首款HBM,23年率先供应新一代HBM3E,先发奠定市场地位,主要供应英伟达,三星供应其他云端厂商,根据TrendForce数据,2022年SK海力士市占率50%、三星市占率40%、美光市占率10%左右,2023年SK海力士市占率预计为53%,三星市占率38%、美光市占率9%。

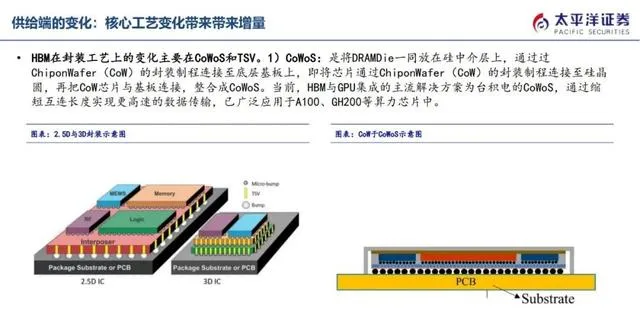

HBM在封装工艺上的变化主要在CoWoS和TSV。

CoWoS,提升数据传输速度,集成GPU的理想解决方案

- CoWoS,将DRAM Die集成于硅中介层上,实现更快速的数据传输。

- 基于ChiponWafer(CoW)封装技术,缩短互连长度,大幅提升数据传输速度。

- 广泛应用于A100、Gp00等高性能计算芯片中。

- 台积电的高效CoWoS解决方案,满足GPU集成需求,带来更大带宽和更高的性能。)CoWoS:是将DRAMDie一同放在硅中介层上,通过过ChiponWafer(CoW)的封装制程连接至底层基板上,即将芯片通过ChiponWafer(CoW)的封装制程连接至硅晶圆,再把CoW芯片与基板连接,整合成CoWoS。当前,HBM与GPU集成的主流解决方案为台积电的CoWoS,通过缩短互连长度实现更高速的数据传输,已广泛应用于A100、Gp00等算力芯片中。

TSV硅通孔是实现HBM容量和带宽扩展的核心技术,在整个硅晶圆厚度上打孔,形成数千个垂直互连,连接芯片正面和背面。HBM中,多层DRAM die堆叠,通过TSV和焊接凸点连接,只有最底部的die能外部连接到存储控制器,其余管芯则通过内部TSV互连。TSV技术显著提升了HBM的性能和密度,使其成为高性能计算和人工智能领域的理想选择。)TSV:TSV硅通孔是实现容量和带宽扩展的核心,通过在整个硅晶圆厚度上打孔,在芯片正面和背面之间形成数千个垂直互连。在HBM中多层DRAMdie堆叠,通过硅通孔和焊接凸点连接,且只有最底部的die能向外连接到存储控制器,其余管芯则通过内部TSV实现互连。

-对此,您有什么看法见解?-

-欢迎在评论区留言探讨和分享。-