Llama2,Gemma,Mistral等大語言開源模型都開源免費給大家使用,但是基於這些模型的使用都要操作一堆程式碼,操作之繁瑣。本期我們就基於ollama一鍵安裝各大開源模型,且可以本地部署使用。告別繁瑣的程式碼編程,不用聯網,本地使用大語言模型。

ollama是一個開源的第三方大語言模型使用外掛程式,我們下載ollama後,可以很方便的使用Llama2,Gemma,Mistral等大語言開源模型。首先到ollama的官網,或者GitHub連結下載ollama進行安裝,其ollama支持window版本,Mac版本,以及Linux版本,可以根據自己的電腦配置下載安裝。由於ollama要使用GPU進行加速運算,因此電腦需要有N卡。

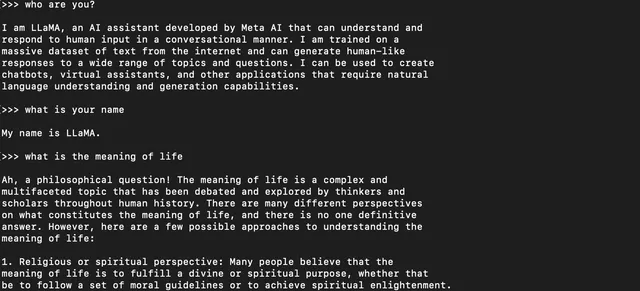

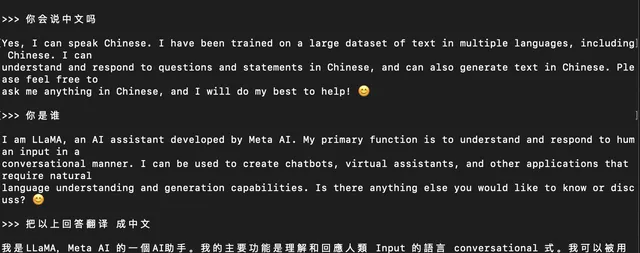

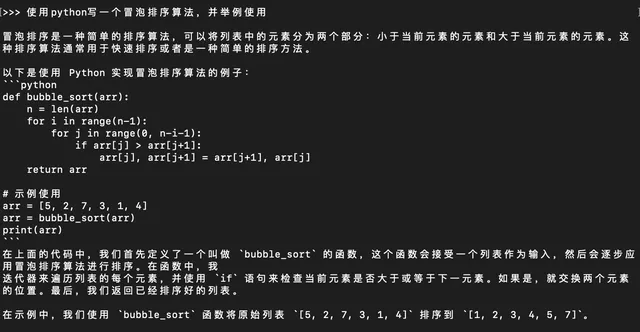

ollama就是一個簡單的軟件,安裝完成後,直接雙擊執行即可,執行後,ollama會執行在後台提供服務,我們只需要進入一個CMD視窗即可。在終端界面輸入ollama run llama2就可以愉快的跟llama2模型聊天了。當然,你若是第一次執行ollama,ollama會自動檢測電腦上是否有相關的開源模型,若沒有相關的開源模型,會自動下載。若是已經下載過llama2,執行以上命令後,會自動開啟llama2大模型。

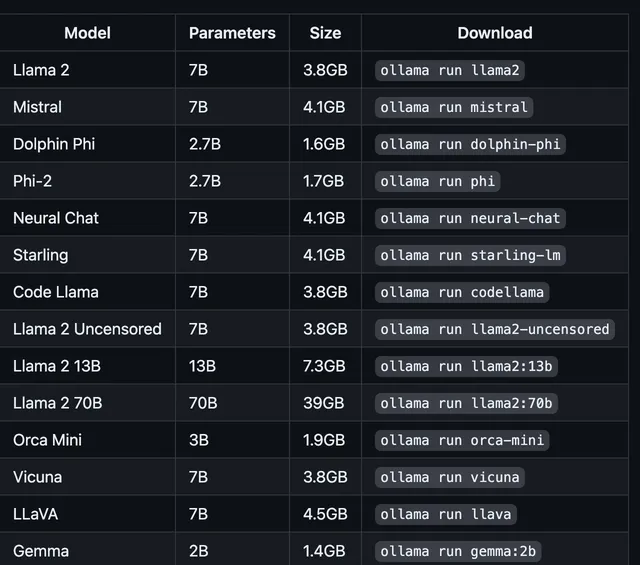

ollama支持主流的幾十種大語言模型,可以直接使用ollama run + 模型的名字來執行,若本地沒有下載過相關的模型,會自動下載,大大節省了操作的流程。這裏模型記錄聊天記錄,能使用中文聊天,當然若想體驗完整的中文,最好下載中文llama模型,或者其他國產開源模型。

當然這裏下載的任何模型都可以進行使用,ollama list可以檢視所有本地電腦安裝好的模型,當然這些大模型也是比較大,若不想使用,也可以使用ollama rm llama2來刪除。

這裏需要註意的是8 GB RAM run 7B models, 16 GB run 13B models, 32 GB run 33B models.這裏需要註意自己的電腦配置。

https://ollama.com/bloghttps://ollama.com/library

當然執行在終端視窗中,雖然是一個界面,但是其界面並不美觀,其實很多UI界面視窗都支持ollama,我們下期分享下其他界面的安裝與使用方法。