電腦視覺研究院專欄

作者:Edison_G

目標檢測中,點特征使用方便,但可能缺乏精確定位的明確邊界資訊。 這個幹貨我覺得不錯,在此和大家分享下!

公眾號ID |ComputerVisionGzq

學習群 |掃碼在主頁獲取加入方式

1

簡述

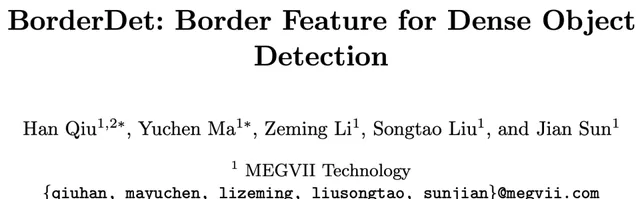

密集物體檢測器依賴於滑動視窗範式,可以在規則的影像網格上預測物體。同時,采用網格點上的特征圖來生成邊界框預測。點特征使用方便,但可能缺乏精確定位的明確邊界資訊。

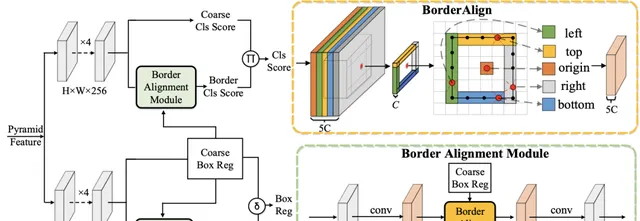

在今天分享中,有研究者提出了一種簡單高效的算子,稱為 Border-Align ,從邊界的極值點提取「 邊界特征 」以增強點特征。基於BorderAlign,研究者設計了一種稱為BorderDet的新型檢測架構,它明確 利用邊界資訊進行更強的分類和更準確的定位 。

2

背景

Sliding Window

滑窗法 作為一種經典的物體檢測方法,個人認為不同大小的視窗在影像上進行滑動時候,進行摺積運算後的結果與已經訓練好的分類器判別存在物體的機率。 選擇性搜尋(Selective Search) 是主要運用影像分割技術來進行物體檢測。

透過滑窗法流程圖可以很清晰理解其主要思路:首先對輸入影像進行不同視窗大小的滑窗進行從左往右、從上到下的滑動。每次滑動時候對當前視窗執行分類器(分類器是事先訓練好的)。如果當前視窗得到較高的分類機率,則認為檢測到了物體。對每個不同視窗大小的滑窗都進行檢測後,會得到不同視窗檢測到的物體標記,這些視窗大小會存在重復較高的部份,最後采用非極大值抑制( Non-Maximum Suppression, NMS )的方法進行篩選。最終,經過NMS篩選後獲得檢測到的物體。

3

新框架分析

滑動視窗目標檢測器通常在密集的、規則的特征圖網格上生成邊界框預測。如上圖所示,網格每個點上的特征一般用於預測目標的類別和位置。這種基於點的特征表示很難包含有效的邊界特征,並且可能會限制目標檢測器的定位能力。對於兩階段目標檢測器,目標由從整個邊界框中提取的區域特征來描述,如上圖(b)所示。這種基於區域的特征表示能夠為目標分類和定位提供比基於點的特征表示更豐富的特征。

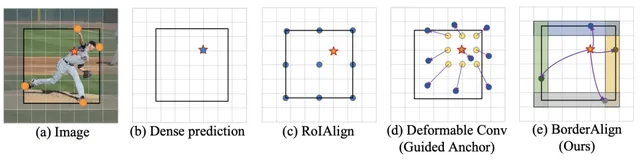

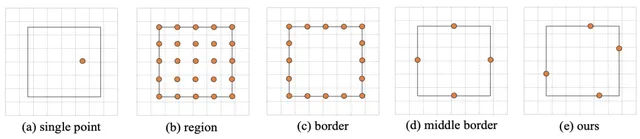

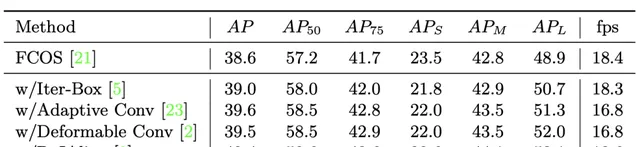

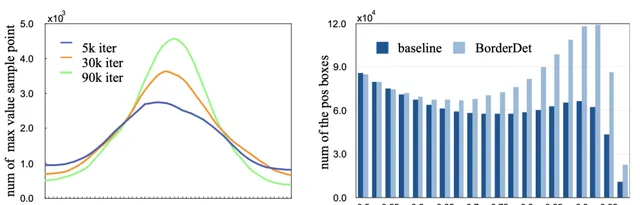

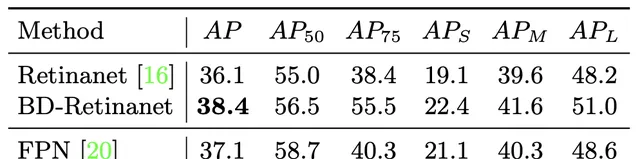

在上表中,研究者對邊界框的特征表示進行了更深入的分析。首先,采用一個簡單的密集目標檢測器(FCOS)作為新框架的基線來生成粗邊界框預測。

Border Align

受R-FCN的啟發,新框架的BorderAlign以具有(4 + 1)C通道的邊界敏感特征圖I作為輸入。特征圖的4C通道對應四個邊界(左、上、右、下)。

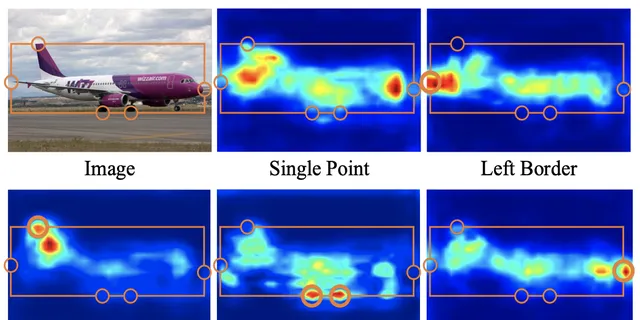

border-sensitive特征圖視覺化

邊界上的橙色圓圈表示極值點。'Single Point', 'Left Border', 'Top Border', 'Right Border' 和 'Bottom Border'的特征圖是邊界敏感特征圖的每個 C 通道的最大特征值。

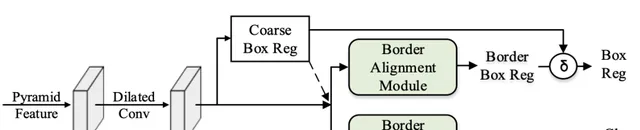

新方法也可以作為典型的兩級檢測器的更好的候選生成器。 研究者將邊界對齊模組添加到RPN並將新結構表示為BorderRPN。BorderRPN的架構如上圖所示。保留RPN中的回歸分支來預測粗邊界框位置。RPN中的第一個3 × 3摺積被替換為3 × 3空洞摺積以增加有效感受野。

4

實驗

在NVIDIA 2080Ti GPU上的測試結果

在某種程度上,可證明BorderAlign確實在提取邊界極限的特征,且邊界極限點的特征對物體的精準定位確實有一些幫助。

© THE END

轉載請聯系本公眾號獲得授權

電腦視覺研究院學習群等你加入!

電腦視覺研究院 主要涉及 深度學習 領域,主要致力於 人臉檢測、人臉辨識,多目標檢測、目標跟蹤、影像分割等 研究方向。 研究院 接下來會不斷分享最新的論文演算法新框架,我們這次改革不同點就是,我們要著重」 研究 「。之後我們會針對相應領域分享實踐過程,讓大家真正體會 擺脫理論 的真實場景,培養愛動手編程愛動腦思考的習慣!

電腦視覺研究院

公眾號ID | ComputerVisionGzq

源碼下載 | 回復「 BD 」獲取源碼下載

🔗