性能:

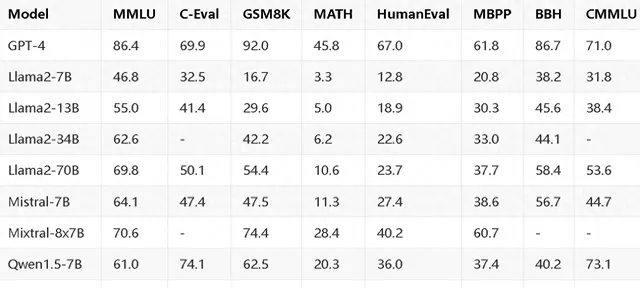

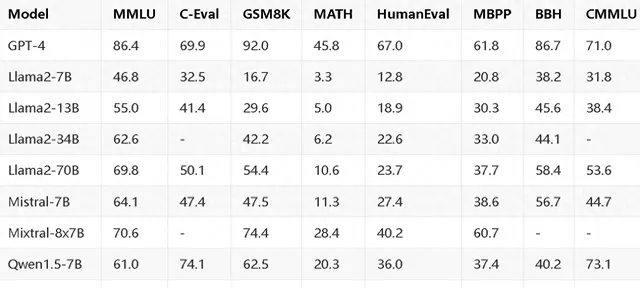

性能评价如下(72B 好于Mixtral-8x7B ):

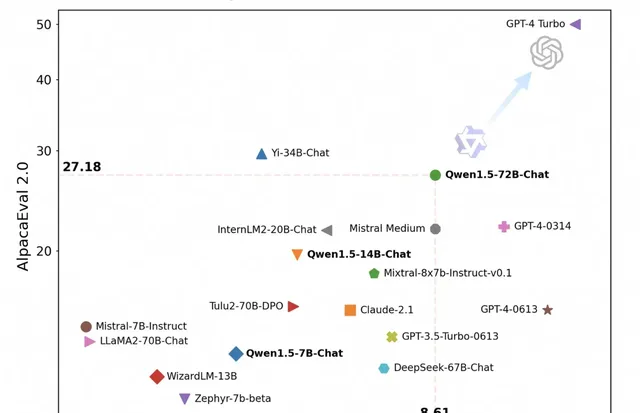

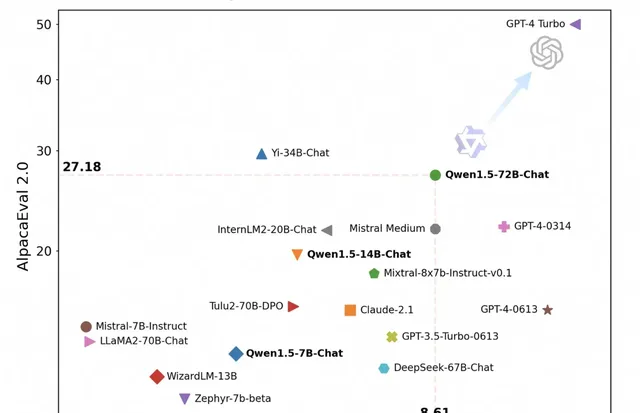

也比自己一代模型强一些,好些不是很多:

综合对比:

HuggingFace原生

Qwen1.5 这次直接与HuggingFace transformers集成结合,不需要再加载任何自定义的代码(trust_remote_code)不需要了。

size 全

地址:

性能:

性能评价如下(72B 好于Mixtral-8x7B ):

也比自己一代模型强一些,好些不是很多:

综合对比:

HuggingFace原生

Qwen1.5 这次直接与HuggingFace transformers集成结合,不需要再加载任何自定义的代码(trust_remote_code)不需要了。

size 全

地址:

Copyright © 2024 www.digfamily.com NO.1 华文头条

商务合作:xingwa#jasve.com(发送邮件请将#换成@)