連結:https://arxiv.org/abs/2304.08460

動機

指令調優使語言模型能夠更有效地泛化,更好地遵循使用者意圖。不過,獲取指令是十分昂貴且具有挑戰性的。現有的方法采用諸如人工註釋、眾包數據集LLM生成雜訊樣例的方法。本文介紹了LongForm數據集,LongForm透過利用英語語料庫的指令構建。本文提出從現有的語料庫選擇文件,並透過LLM基於文件生成指令。這種方法提供了一個更便宜、更幹凈的指令調優數據集。

本文在該數據集上微調T5,OPT和LLaMA模型,結果表明即使是較小的LongForm模型也具有良好的文本生成泛化能力。其無需對不同特定任務進行指令調整,便能取得比更大模型好的效果。

方法

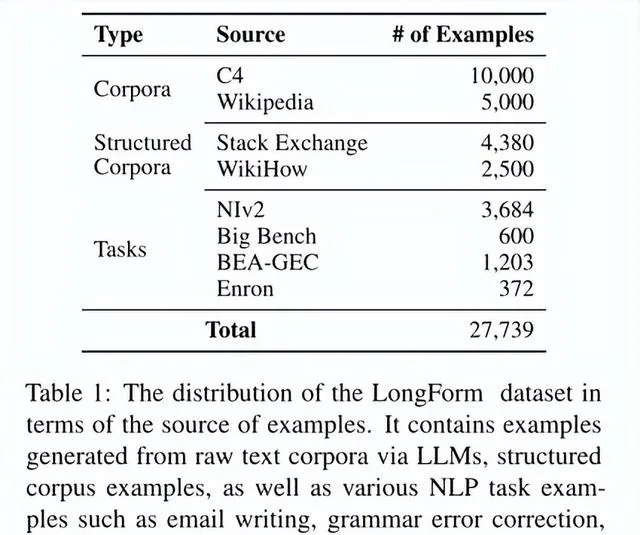

從語料庫生成指令。本文從C4語料庫中抽取了10000個樣本,從英語維基百科中抽取了5000個樣本。使用OpenAI的text-davinci-003模型作為LLM。設計了提示LLM針對一個給定的文件生成指令的prompt。本文建立了三個樣版來使我們的指令風格多樣化:正式指令風格、非正式聊天機器人風格和搜尋引擎查詢風格,概率分別為50%、30%和20%。

(1)本文提供了樣版,在生成指令時加入長度限制資訊。例如「以D句回應」或「以D詞回應」,其中D表示目標文本的單詞或句子的數量。

(2)本文同時也從結構化語料庫不適用LLM直接收集數據作為語料庫的擴充套件。

本文使用LLM生成指令,為了保證質素,采取了人工評估的方式。隨機選取100個樣本,要求人工判定指令是否與給定文件相關。實驗發現100條指令中有97條是相關的。這種高度的相關性表明,與Self-Instruct數據集相比,將指令生成與語料庫樣例相結合可以潛在地提高用於指令生成的LLM的有效性。

實驗與結果

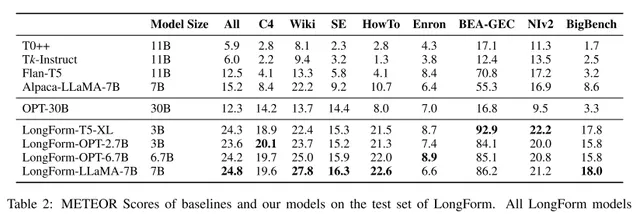

本文使用LongForm數據集微調了T5-3B、OPT、LLaMA-7B模型,以評估instruction following文本生成的有效性。選擇T0++、Tk-Instruct、Flan-T5、Alpaca-LLaMA-7B這三個指令微調模型和未經指令微調的OPT-30B作為baseline。

所有LongForm模型與之前的指令微調模型和原始LLM相比,都表現出明顯的效能改進。3B參數的LongForm-T5-XL在所有子任務中的效能均優於具有11B參數的Flan-T5。

總結

本文中提出了名為LongForm的指令遵循長文本生成數據集,結合語料庫的樣例與LLM生成的指令、結構化語料庫的例項。作者的評估表明,生成的指令與語料庫高度相關,並包含了類別多樣的任務。此外,本文證明了在LongForm數據集上進行指令微調的模型在各種指令長文本生成任務相較baseline具有很大的優勢。