沒有演算法沒有實驗,從2610篇收錄論文中脫穎而出,成為唯一一篇 純理論 入選2024 ICML Spotlight的論文。

「 Vocabulary for Universal Approximation: A Linguistic Perspective of Mapping Compositions (詞的萬能逼近:從語言角度看對映組合)」,這篇純理論論文講了什麽,何以入選Spotlight?

簡單來說,目前基於深度學習的序列模型,如語言模型,受到了廣泛關註並取得了成功,這促使研究人員探索 將非序列問題轉換為序列形式 的可能性。

沿著這一思路,深度神經網絡可以表示為一系列線性或非線性對映的 復合函數 ,其中每個對映都可以看作是一個 「詞」 。

然而,線性對映的權重是未確定的,因此需要無限多個詞。

而這篇論文研究有限情形並構造性地證明了存在一個 有限的函數詞匯表V ,用於實作萬能逼近。

也就是說,對於任何連續對映f、緊集Ω和ε>0,存在V中的一個有限序列,使得它們的復合對映能夠在Ω上近似f且逼近誤差小於ε。

論文研究結果展示了函數復合的非凡近似能力,並為正則語言提供了新的模型。

這項研究由北京師範大學蔡永強完成,在2024 ICML的2610篇收錄論文中,144篇是Oral,191篇是Spotlight。但初步盤點在今年的Oral和Spotlight論文中,僅有這一篇是沒有演算法沒有實驗的純理論文章。

下面我們來看看具體內容。

認知心理學家和語言學家早已認識到語言對於智能的重要性,而BERT和GPT等語言模型的流行進一步凸顯了這一點。

這些基於RNN或Transformer的模型透過將自然語言處理轉化為序列學習問題,徹底改變了自然語言處理的研究方向。它們可以處理文本中的長程依賴性,並根據上下文內容生成連貫的文本,這使它們成為語言理解和生成方面的重要工具。

這些模型的成功還催生了一種透過 將非序列問題轉化為序列問題來解決非序列問題 的新方法。

例如,影像處理可以轉化為序列學習問題,將影像分割成小塊,將它們按一定順序排列,然後使用序列學習演算法處理得到的序列以實作影像辨識。

序列學習演算法的使用還可以擴充套件到強化學習領域,例如Decision Transformer透過利用因果掩碼Transformer輸出最佳動作,可以取得很好的效能。

序列建模為解決各種問題開辟了新的可能性,這種趨勢似乎在理論研究領域也得到了體現。

眾所周知, 人工神經網絡具有萬能逼近能力,寬或深的前饋網絡可以任意逼近緊集上的連續函數 。

然而,在AlphaFold、BERT和GPT等實際套用中,殘留誤差網絡結構比前饋結構更受青睞。據觀察,殘留誤差網絡(ResNet)可以視為動力系統的前向歐拉離散,這種關系催生了一系列基於動力系統的神經網絡結構,例如連續情形的Neural ODE等。基於動力系統的神經網絡結構有望在各個領域發揮重要作用。

值得註意的是,語言模型和動力系統都與時間序列建模相關,並且已有效地套用於非序列問題。

這一觀察自然會讓我們產生疑問:

語言模型和時間序列建模各自的成功之間是否存在內在聯系?

本文這項研究就是在探究這一問題。

透過比較研究,作者從萬能逼近的角度得到了一些初步結果。具體來說,可以證明 存在有限個對映 ,稱為詞匯表,(其中的對映可以取為一些自治動力系統的流對映),使得任何連續對映可以透過復合詞匯表中的一個系列來近似。

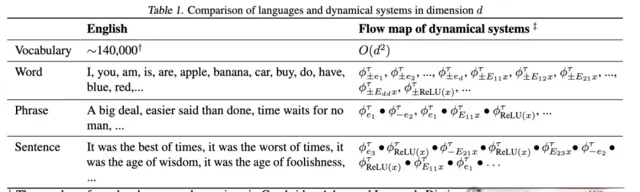

這與自然語言中基於詞來構建短語、句子、段落和篇章來傳達復雜資訊的方式相似。

下表1直觀地體現了這種相似性。

總結來說,研究有以下幾個貢獻:

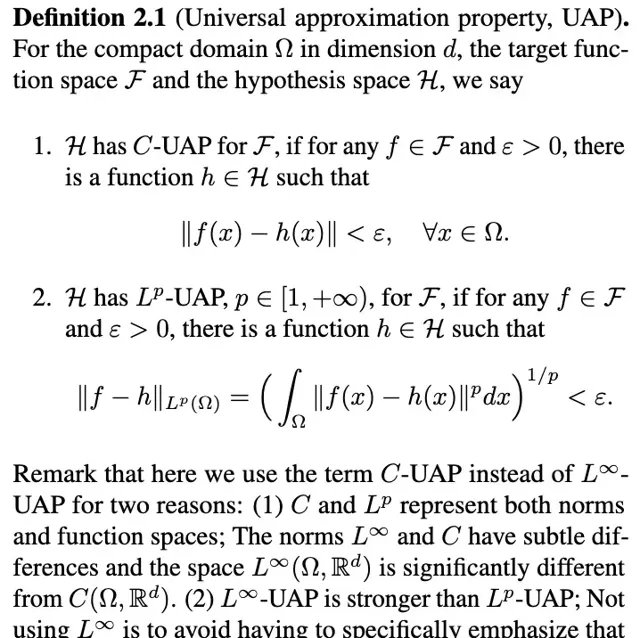

對深度學習有所了解的讀者應該都聽說過萬能逼近定理,它指的是神經網絡可以近似任意的連續函數。

「近似」需要明確是在什麽意義之下,下面是兩種常見的刻畫,本文稱為C-UAP和Lᴾ-UAP,其中C-UAP更強一些。

萬能逼近性質

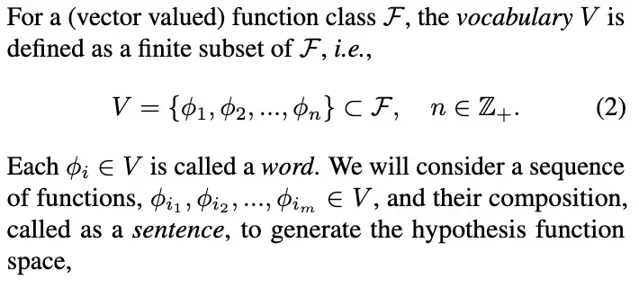

為了表述本文的新型萬能逼近定理,需要給出如下記號:

有限詞匯表

核心是將V稱為詞匯表,V中的對映稱為「詞」,V中一個序列的復合稱為「句子」,所有「句子」的集合記為HV。記號中的實心點表示的是函數復合,計算時先復合最左邊的函數。與常規的復合函數記號相比,有下面的關系:

函數復合

這裏之所以要引入新的記號,而不是直接用復合函數的常規記號,是因為常規記號中最先運算的函數是寫在最後邊,這個相反的順序不便於書寫。

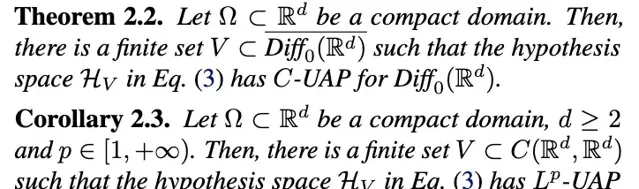

定理本文的主要定理表述如下:

主要結論

定理2.2比較技巧性,記號:

表示的是d維保持定向的微分同胚組成的集合,根據Brenier&Gangbo於2003證明的結論(保持定向的微分同胚可以近似連續函數,前提是維數d大於等於2)可以得到推論2.3。

推論2.3表明「句子」的集合HV具有萬能逼近性質。這與傳統的萬能逼近具有本質的區別。

證明思路定理的證明涉及的知識要點羅列如下:

(1)保持定向的微分同胚可以近似連續函數(Brenier & Gangbo, 2003 )

(2)保持定向的微分同胚可以用微分方程式的流對映來近似(Agrachev & Caponigro, 2010)

(3)常微分方程式可以使用算子分裂格式來近似求解(Holden et al., 2010)

(4)單隱藏層的神經網絡可以近似任意連續函數(Cybenko, 1989)

(5)流對映是單參數的,對於單參數t,可以用形如p+q√2形式的數來近似,其中p,q是整數(Kronecker逼近定理)

基於要點 (3) 和 (4),作者曾證明了d維流對映可以用寬度為d(深度不限)的全連線神經網絡來近似,並在此基礎上研究了神經網絡具有萬能逼近的最小寬度問題,本文進一步結合其余要點得到了詞匯表的萬能逼近定理。

要點 (5) 起到非常關鍵的作用,它是數論裏面比較基礎的結論之一,讀者可能比較熟悉的版本是:考慮無理數(比如圓周率π)的整數倍,其小數部份在[0,1]區間上是稠密的。

備註:作為上述思路的一個練習,讀者可以嘗試證明矩陣(線性對映)版本的定理:考慮d階方陣,存在有限個方陣的集合V,使得任意的方陣都可以用V中的一個序列的乘積來近似(證明見原論文附錄 D,思路是考慮初等矩陣,它們是單參數的)。

總結與啟發本文主要是證明了萬能逼近可以像使用語言一樣達到,傳達的都是「用有限個字表達無限的思想」,主要結論先後投了NeurIPS和ICLR但都被拒了,6+4位元審稿人都覺得結論很有意思但不清楚有什麽用(ICLR 的審稿意見見OpenReview)。

作者表示吸取了審稿人的建議,在投ICML的版本中加入了對正則語言(形式語言中最簡單的一種)的探討(見定理 5.2),並討論了對自然語言處理方法的啟發,這才得以接收。

文章之所以被選為Spotlight,可能是因為定理暗示我們可以考慮將詞嵌入為函數(而非向量),這對於理解和構建人工智能模型具有一定的啟發性。

在自然語言處理中,準確刻畫詞和句子的語意至關重要。

眾所周知的詞向量嵌入提供了一個很好的基線,具有相似語意的單詞具有相似的詞向量。然而,由於靜態詞向量無法描述多義詞的不同語意以及上下文的影響,人們開發了動態詞向量模型以及更復雜的大語言模型,如BERT和GPT。

然而,如何解釋預訓練語言模型是一個困難的問題。

作者指出了本文的定理隱含的結論是,如果將語意表示為函數(這是一個比向量空間大得多的空間),那麽我們可以透過復合一序列來自函數詞匯表中的函數來近似任何語意。

這就是本文第5節中提出的復合流空間模型(CFSM)。

從頭訓練這樣一個CFSM是困難而耗時的。一種替代方案是直接從LLM(如Llama)中提取嵌入的函數,然後觀察CFSM在多大程度上可以恢復LLM的功能。

人類的自然語言是非常復雜的,將詞嵌入為函數雖然比將詞嵌入為向量更具一般性,但依然是Toy模型。

作者表示本文期望能對工程師們有所啟發,重新審視「詞嵌入」這個術語,或特許以對理解 Transformer,Mamba,RNN,TTT等模型,以及提出新的模型帶來新的視角。

作者最後還附上1889年4月26日出生於奧地利維也納省的語言哲學家路德維希‧約瑟夫‧約翰‧維特根斯坦的兩句名言:

「The limits of my language mean the limits of my world.」(我的語言的界限即是我的世界的界限。)

「The meaning of a word is its use in the language.」(一個詞的意義在於它在語言中的使用。)

論文連結:https://proceedings.mlr.press/v235/cai24a.html

— 完 —