金磊 发自 凹非寺

量子位 | 公众号 QbitAI

2024年,AI的发展会有怎样的改变?

在 吴恩达 最新的一封来信中,他认为有几件事情在接下来十年内都不会发生改变。

(以下是吴恩达来信原文)

亲爱的朋友们,

人工智能的发展速度超过以往任何时期,这一现象令人振奋。然而,快速变化可能导致迷失方向。在这种情况下,遵循杰夫·贝佐斯(Jeff Bezos)的建议是非常有益的,不仅要考虑变化中的因素,还要思考那些保持不变的因素。如果事物没有改变,投入精力和努力就更加值得。

以下是我相信AI在未来十年不会改变的一些事情:

那么上述三点对我们每个人意味着什么?

虽然以上三点与人工智能有关,但我想分享另外两件事,不幸的是,我相信它们在未来十年将保持不变:⑴气候变化将继续成为人类面临的重大挑战。⑵贫穷,许多人几乎(甚至可能买不起)基本必需品,仍将是一个问题。我将继续思考人工智能气候建模如何帮助前者,以及我们如何利用人工智能来提升每个人的生活质量。

以上便是吴恩达对于未来AI发展的最新观点。

而就在新年伊始的这几天,AI圈中的多位大佬们也陆续发表了他们对于今年人工智能技术发展的预测。

被LeCun点赞的八大预测

最近,Meta一位研究员Martin Signoux写下了他认为AI在今年发展中的八大预测,而这些预测也得到了LeCun的高度认可。

(以下是Martin Signoux预测的原文)

一、AI智能眼镜会成为现实

随着多模态技术的兴起,领先的人工智能公司将加倍投入人工智能优先的可穿戴设备。

还有什么比眼镜外形更适合托管 AI 助手的呢?

眼镜腿靠近耳朵来传递音频,摄像头靠近眼睛来捕捉看到的输入,它们解放了我们的双手并且佩戴起来也很舒服。

我们和RayBan一起引领着这波潮流,但想想最近的OpenAI和Snapchat传闻……我们的故事才刚刚开始。

二、ChatGPT之于人工智能助手,不会像谷歌之于搜索

2023年是以ChatGPT作为开始,以Bard、Claude、Llama、Mistral和数千个衍生品作为结束。

随着商品化的继续,ChatGPT将随着参考估值修正而消失。

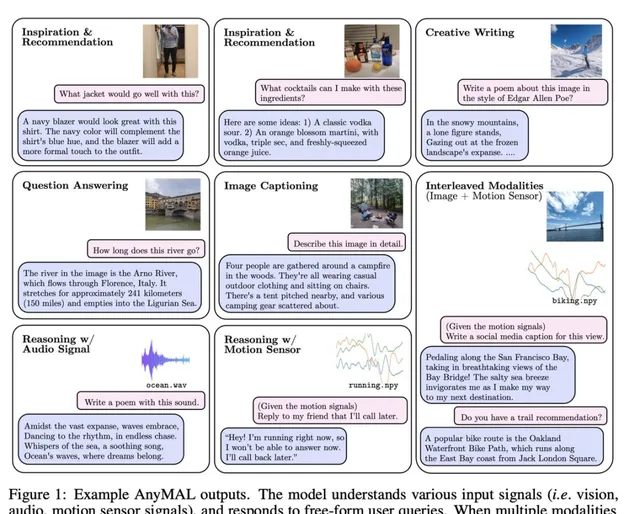

三、再见LLM,你好LMM

大型多模态模型(LMM)将持续涌现,并在热议中取代大型语言模型,包括多模态评估、多模态安全等等。

此外,LMM是迈向真正通用人工智能助手的一块垫脚石。

四、没有重大突破,但各方面都有所改善

新模型不会带来真正的突破(GPT5不会出现),大型语言模型仍将具有内在限制并容易产生幻觉。我们不会看到任何飞跃进展让它们在2024年能足够可靠地「解决基本通用人工智能(AGI)问题」。

迭代改进将使它们「足够好」地完成各种任务。RAG、数据管理、更好的微调、量化等方面的改进将使LLM在许多用例中足够鲁棒/有用,从而推动各行各业各种服务的采用。

五、小即是美

小型语言模型(SLM)已经存在,但成本效率和可持续性的考虑将加速这一趋势。

量化也将大大改善,推动消费者服务的设备上集成的主要浪潮。

六、开源模型将击败GPT-4,开源闭源之争将逐渐消失

回顾过去12个月开源社区所取得的活力和进步,很明显,开源模型将很快缩小性能差距。

我们在2023年底结束时,Mixtral和GPT-4在MMLU(多模态学习理解)测试中的差距仅剩13%。

但最重要的是,大家都意识到了开源模型将持续存在并推动进步,它们将与专有模型共存。

七、基准测试仍然会是个难题

没有一套基准测试、排行榜或评估工具成为模型评估的终极选择。

相反,我们将看到一系列的改进(就像最近的HELM)和新的倡议(如GAIA),特别是在多模态方面。

八、相比于现存风险,关于存在性风险的讨论不会太多

虽然2023年X-risks成为了头条新闻,但公众辩论将更多地集中在当前的风险和争议上,比如偏见、假新闻、用户安全等问题。

Runway CTO:用新工具讲新故事

Runway联合创始人兼CTO Anastasis Germanidis也发表了他对于今年AI发展的看法。

(以下是Anastasis Germanidis预测的原文)

2023年是广泛应用人工智能系统(涵盖文本、图像、视频、音频和其他模态)发展的转折点。

仅在Runway公司,我们就看到了如Gen-1和Gen-2这样的视频生成模型的发布,以及使这些模型具有新型创造控制形式的工具。

在未来一年,我预计在以下几个领域会看到持续的进展:

除了技术进步之外,构建这些系统最有意义的部分是,随着每次更新和能力的增强,新的受众被引入其中,讲述了以前没有讲过的新故事。我很兴奋地看到这将在未来一年继续发生。

斯坦福副教授:基础模型的透明度

斯坦福大学计算机科学副教授Percy Liang,则是将关注点聚焦到了基础模型的透明度上。

(以下是Percy Liang预测的原文)

仅仅一年前,ChatGPT让世界意识到了基础模型的力量。但这种力量不仅仅体现在耀眼、令人瞠目的演示上。基础模型将以与计算和互联网在上一代社会变革中相似的方式,渗透到我们生活的每个领域、每个方面。考虑到这种预期影响的广度,我们不仅要问人工智能能做什么,还要问它是如何构建的。它是如何被管理的?谁来决定?

我们真的不知道。这是因为人工智能的透明度正在下降。在2010年代的大部分时间里,开放是默认的取向:研究人员发布论文、代码和数据集。在过去三年里,透明度减弱了。

关于最先进模型(如GPT-4、Gemini和Claude)的公开信息很少:用于训练它们的数据是什么?谁创建了这些数据,劳动实践如何?这些模型与哪些价值观相一致?这些模型在实践中是如何使用的?没有透明度,就没有问责,我们已经见证了缺乏透明度在社交媒体等以前一代技术中产生的问题。

为了使透明度评估严谨,基础模型研究中心引入了基础模型透明度指数,用于描述基础模型开发者的透明度。好消息是,许多透明度方面(例如,拥有适当的文档)是可实现的,并且与公司的激励相符。在2024年,也许我们可以开始逆转这一趋势。

目前,政策制定者普遍认识到需要管理人工智能。除了透明度,首要优先事项之一是评估。事实上,没有科学基础来理解这些模型的能力和风险,我们就是盲目的。大约一年前,基础模型研究中心发布了综合评估语言模型(HELM),这是一个评估基础模型(包括语言模型和图像生成模型)的资源。现在我们正在与MLCommons合作,开发一个安全评估的行业标准。

但这个评估很难,尤其是对于通用、开放式的系统。你如何覆盖几乎无限的使用案例和潜在危害空间?你如何防止操纵?你如何以公众能理解的方式呈现结果?这些都是开放的研究问题,但我们需要在短时间内解决这些问题,以跟上人工智能的快速发展。我们需要整个研究社区的帮助。

想象ChatGPT式助手将成为我们获取信息和做出决策的主要方式,并不遥远。因此,基础模型的行为——包括任何偏见和偏好——是重要的。

据说这些模型与人类价值观相一致,但我们谈论的是哪些价值观?再次,由于缺乏透明度,我们无法看到这些价值观是什么,以及它们是如何确定的。我们能否想象一个更民主的过程来引出价值观,而不是由单一组织做出这些决定?重要的是这个过程的正直性和合法性。

OpenAI希望在这方面资助工作,Anthropic也有一些这方向的研究,但这些都还处于早期阶段。我希望其中一些想法能够被纳入生产系统。

微软CTO:为下一年的指数增长做好准备

微软CTO Kevin Scott也做出他对AI在今年发展的一些预测。

(以下是Kevin Scott预测的原文)

毫无疑问,2023年是我在相当长的职业生涯中见过的最激动人心、最有趣的技术年份。

值得一提的是,我很确定在2022年结束时我也说过类似的话,我怀疑我明年这个时候可能还会说同样的话,以及在可预见的未来的每一年——重点是,现在的人工智能领域,我们正在经历一个持续的指数级增长时期,这可能代表了我们所见过的最深刻的技术进步。

而且这只是开始。现代生成型人工智能仍处于婴儿期,我们在学习中前行。尽管感觉我们已经和它们共存了很长时间,但2023年实际上是像ChatGPT和Microsoft Copilots这样的强大人工智能工具真正有意义地进入公众视野,作为有用的助手让人们的生活更轻松的第一年。

到明年结束时,我们将拥有许多新的体验、应用和工具,为全世界越来越多的人带来层层叠加的好处。尽管人工智能增长的炒作幅度和加速率可能让人们专注于每一个接下来的「下一个大事件」,但如果我们稍微退后一点,就更容易看到我们面前的机会比我们已经实现的要大得多。

因为我们只能每隔几年左右才能体验到指数曲线的产物,最近一次是GPT-4,我们很容易在这段时间忘记增长的速度实际上有多惊人。而且,按照我们人类的本性,我们很快就适应了,并很快就将每一套新出现的疯狂可能性视为理所当然。

因此,我对所有在未来一年从事人工智能和技术工作的人的希望是,我们需要意识到,指数曲线的下一个样本即将到来,并适当地为(肯定会令人难以置信的)结果做好准备。

愿2024年继续为我们所有人带来发现的激动和持续的创新。

那么,你认为今年AI的发展还有什么值得我们期待呢?

参考链接:

[1]https://twitter.com/MartinSignoux/status/1740729650530365646

[2]https://twitter.com/AndrewYNg/status/1741892184977309823

[3]https://www.deeplearning.ai/the-batch/issue-229/

[4]https://twitter.com/ylecun/status/1740830697181655432

— 完 —

量子位 QbitAI · 头条号签约

关注我们,第一时间获知前沿科技动态