金磊 發自 凹非寺

量子位 | 公眾號 QbitAI

2024年,AI的發展會有怎樣的改變?

在 吳恩達 最新的一封來信中,他認為有幾件事情在接下來十年內都不會發生改變。

(以下是吳恩達來信原文)

親愛的朋友們,

人工智慧的發展速度超過以往任何時期,這一現象令人振奮。然而,快速變化可能導致迷失方向。在這種情況下,遵循傑夫·貝佐斯(Jeff Bezos)的建議是非常有益的,不僅要考慮變化中的因素,還要思考那些保持不變的因素。如果事物沒有改變,投入精力和努力就更加值得。

以下是我相信AI在未來十年不會改變的一些事情:

那麽上述三點對我們每個人意味著什麽?

雖然以上三點與人工智慧有關,但我想分享另外兩件事,不幸的是,我相信它們在未來十年將保持不變:⑴氣候變遷將繼續成為人類面臨的重大挑戰。⑵貧窮,許多人幾乎(甚至可能買不起)基本必需品,仍將是一個問題。我將繼續思考人工智慧氣候建模如何幫助前者,以及我們如何利用人工智慧來提升每個人的生活品質。

以上便是吳恩達對於未來AI發展的最新觀點。

而就在新年伊始的這幾天,AI圈中的多位大佬們也陸續發表了他們對於今年人工智慧技術發展的預測。

被LeCun點贊的八大預測

最近,Meta一位研究員Martin Signoux寫下了他認為AI在今年開發中的八大預測,而這些預測也得到了LeCun的高度認可。

(以下是Martin Signoux預測的原文)

一、AI智慧眼鏡會成為現實

隨著多模態技術的興起,領先的人工智慧公司將加倍投入人工智慧優先的可穿戴裝置。

還有什麽比眼鏡外形更適合托管 AI 助手的呢?

眼鏡腿靠近耳朵來傳遞音訊,網路攝影機靠近眼睛來捕捉看到的輸入,它們解放了我們的雙手並且佩戴起來也很舒服。

我們和RayBan一起引領著這波潮流,但想想最近的OpenAI和Snapchat傳聞……我們的故事才剛剛開始。

二、ChatGPT之於人工智慧助手,不會像谷歌之於搜尋

2023年是以ChatGPT作為開始,以Bard、Claude、Llama、Mistral和數千個衍生品作為結束。

隨著商品化的繼續,ChatGPT將隨著參考估值修正而消失。

三、再見LLM,你好LMM

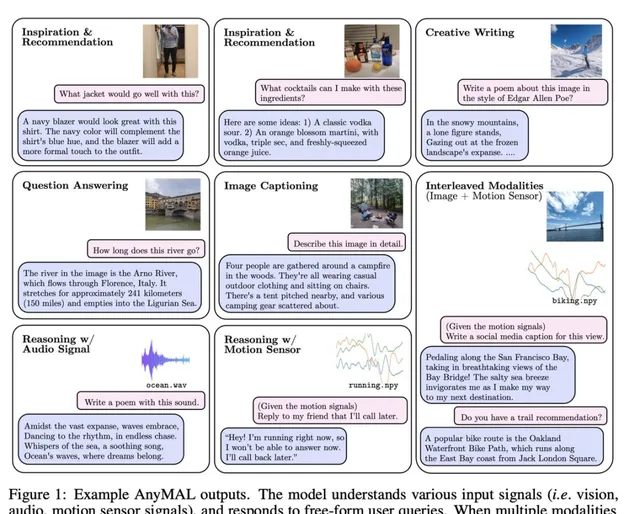

大型多模態模型(LMM)將持續湧現,並在熱議中取代大型語言模型,包括多模態評估、多模態安全等等。

此外,LMM是邁向真正通用人工智慧助手的一塊墊腳石。

四、沒有重大突破,但各方面都有所改善

新模型不會帶來真正的突破(GPT5不會出現),大型語言模型仍將具有內在限制並容易產生幻覺。我們不會看到任何飛躍進展讓它們在2024年能足夠可靠地「解決基本通用人工智慧(AGI)問題」。

叠代改進將使它們「足夠好」地完成各種任務。RAG、數據管理、更好的微調、量化等方面的改進將使LLM在許多用例中足夠魯棒/有用,從而推動各行各業各種服務的采用。

五、小即是美

小型語言模型(SLM)已經存在,但成本效率和永續性的考慮將加速這一趨勢。

量化也將大大改善,推動消費者服務的裝置上整合的主要浪潮。

六、開源模型將擊敗GPT-4,開源閉源之爭將逐漸消失

回顧過去12個月開源社群所取得的活力和進步,很明顯,開源模型將很快縮小效能差距。

我們在2023年底結束時,Mixtral和GPT-4在MMLU(多模態學習理解)測試中的差距僅剩13%。

但最重要的是,大家都意識到了開源模型將持續存在並推動進步,它們將與專有模型共存。

七、基準測試仍然會是個難題

沒有一套基準測試、排行榜或評估工具成為模型評估的終極選擇。

相反,我們將看到一系列的改進(就像最近的HELM)和新的倡議(如GAIA),特別是在多模態方面。

八、相比於現存風險,關於存在性風險的討論不會太多

雖然2023年X-risks成為了頭條新聞,但公眾辯論將更多地集中在當前的風險和爭議上,比如偏見、假新聞、使用者安全等問題。

Runway CTO:用新工具講新故事

Runway聯合創始人兼CTO Anastasis Germanidis也發表了他對於今年AI發展的看法。

(以下是Anastasis Germanidis預測的原文)

2023年是廣泛套用人工智慧系統(涵蓋文本、影像、視訊、音訊和其他模態)發展的轉折點。

僅在Runway公司,我們就看到了如Gen-1和Gen-2這樣的視訊生成模型的釋出,以及使這些模型具有新型創造控制形式的工具。

在未來一年,我預計在以下幾個領域會看到持續的進展:

除了技術進步之外,構建這些系統最有意義的部份是,隨著每次更新和能力的增強,新的受眾被引入其中,講述了以前沒有講過的新故事。我很興奮地看到這將在未來一年繼續發生。

史丹佛副教授:基礎模型的透明度

史丹佛大學電腦科學副教授Percy Liang,則是將關註點聚焦到了基礎模型的透明度上。

(以下是Percy Liang預測的原文)

僅僅一年前,ChatGPT讓世界意識到了基礎模型的力量。但這種力量不僅僅體現在耀眼、令人瞠目的演示上。基礎模型將以與計算和互聯網在上一代社會變革中相似的方式,滲透到我們生活的每個領域、每個方面。考慮到這種預期影響的廣度,我們不僅要問人工智慧能做什麽,還要問它是如何構建的。它是如何被管理的?誰來決定?

我們真的不知道。這是因為人工智慧的透明度正在下降。在2010年代的大部份時間裏,開放是預設的取向:研究人員釋出論文、程式碼和數據集。在過去三年裏,透明度減弱了。

關於最先進模型(如GPT-4、Gemini和Claude)的公開資訊很少:用於訓練它們的數據是什麽?誰建立了這些數據,勞動實踐如何?這些模型與哪些價值觀相一致?這些模型在實踐中是如何使用的?沒有透明度,就沒有問責,我們已經見證了缺乏透明度在社交媒體等以前一代技術中產生的問題。

為了使透明度評估嚴謹,基礎模型研究中心引入了基礎模型透明度指數,用於描述基礎模型開發者的透明度。好訊息是,許多透明度方面(例如,擁有適當的文件)是可實作的,並且與公司的激勵相符。在2024年,也許我們可以開始逆轉這一趨勢。

目前,政策制定者普遍認識到需要管理人工智慧。除了透明度,首要優先事項之一是評估。事實上,沒有科學基礎來理解這些模型的能力和風險,我們就是盲目的。大約一年前,基礎模型研究中心釋出了綜合評估語言模型(HELM),這是一個評估基礎模型(包括語言模型和影像生成模型)的資源。現在我們正在與MLCommons合作,開發一個安全評估的行業標準。

但這個評估很難,尤其是對於通用、開放式的系統。你如何覆蓋幾乎無限的使用案例和潛在危害空間?你如何防止操縱?你如何以公眾能理解的方式呈現結果?這些都是開放的研究問題,但我們需要在短時間內解決這些問題,以跟上人工智慧的快速發展。我們需要整個研究社群的幫助。

想象ChatGPT式助手將成為我們獲取資訊和做出決策的主要方式,並不遙遠。因此,基礎模型的行為——包括任何偏見和偏好——是重要的。

據說這些模型與人類價值觀相一致,但我們談論的是哪些價值觀?再次,由於缺乏透明度,我們無法看到這些價值觀是什麽,以及它們是如何確定的。我們能否想象一個更民主的過程來引出價值觀,而不是由單一組織做出這些決定?重要的是這個過程的正直性和合法性。

OpenAI希望在這方面資助工作,Anthropic也有一些這方向的研究,但這些都還處於早期階段。我希望其中一些想法能夠被納入生產系統。

微軟CTO:為下一年的指數增長做好準備

微軟CTO Kevin Scott也做出他對AI在今年發展的一些預測。

(以下是Kevin Scott預測的原文)

毫無疑問,2023年是我在相當長的職業生涯中見過的最激動人心、最有趣的技術年份。

值得一提的是,我很確定在2022年結束時我也說過類似的話,我懷疑我明年這個時候可能還會說同樣的話,以及在可預見的未來的每一年——重點是,現在的人工智慧領域,我們正在經歷一個持續的指數級增長時期,這可能代表了我們所見過的最深刻的技術進步。

而且這只是開始。現代生成型人工智慧仍處於嬰兒期,我們在學習中前行。盡管感覺我們已經和它們共存了很長時間,但2023年實際上是像ChatGPT和Microsoft Copilots這樣的強大人工智慧工具真正有意義地進入公眾視野,作為有用的助手讓人們的生活更輕松的第一年。

到明年結束時,我們將擁有許多新的體驗、套用和工具,為全世界越來越多的人帶來層層疊加的好處。盡管人工智慧增長的炒作振幅和加速率可能讓人們專註於每一個接下來的「下一個大事件」,但如果我們稍微退後一點,就更容易看到我們面前的機會比我們已經實作的要大得多。

因為我們只能每隔幾年左右才能體驗到指數曲線的產物,最近一次是GPT-4,我們很容易在這段時間忘記增長的速度實際上有多驚人。而且,按照我們人類的本性,我們很快就適應了,並很快就將每一套新出現的瘋狂可能性視為理所當然。

因此,我對所有在未來一年從事人工智慧和技術工作的人的希望是,我們需要意識到,指數曲線的下一個樣本即將到來,並適當地為(肯定會令人難以置信的)結果做好準備。

願2024年繼續為我們所有人帶來發現的激動和持續的創新。

那麽,你認為今年AI的發展還有什麽值得我們期待呢?

參考連結:

[1]https://twitter.com/MartinSignoux/status/1740729650530365646

[2]https://twitter.com/AndrewYNg/status/1741892184977309823

[3]https://www.deeplearning.ai/the-batch/issue-229/

[4]https://twitter.com/ylecun/status/1740830697181655432

— 完 —

量子位 QbitAI · 頭條號簽約

關註我們,第一時間獲知前沿科技動態